He aquí cómo funciona el efecto Desenfoque de lente de la cámara Google

Profundidad ajustable de los efectos del campo son las nuevas características de la cámara caliente incluidas en tanto el nuevo Samsung Galaxy S5 y HTC uno M8. Si no te apetece comprar un nuevo teléfono, el recién lanzado Google cámara App incluye una característica similar también. La profundidad de campo es ideal para añadir un poco de "chispa" a sus imágenes, con lo que las cámaras de teléfonos inteligentes una característica más cerca de sus primos SLR.

Por un poco de historia, Desenfoque de lente de Google le permite cambiar el punto o nivel de enfoque de una imagen incluso después de la foto ha sido tomada, de una manera similar a Samsung Foco el modo en el GS5. Tocando en una parte de la imagen ajusta el punto focal, mientras que un control deslizante se usa para ajustar la fuerza del efecto en tiempo real. Si desea saber cómo funciona el efecto Desenfoque de lente de software de Google basa, entonces sigue leyendo.

Como la aplicación se utiliza en dispositivos que sólo tienen una sola cámara, el primer paso es capturar múltiples imágenes desde muy ligeramente diferentes posiciones como base para comenzar a recopilar información de profundidad. En lugar de la captura de una sola foto, mueve la cámara en un barrido hacia arriba para captar toda una serie de fotogramas. A partir de estas imágenes, el software crea un modelo virtual en 3D de la escena mediante referencias cruzadas píxeles de la imagen de la serie.

Modelos 3D se pueden crear a partir de imágenes capturadas desde múltiples posiciones. Aunque con los teléfonos inteligentes, el ángulo de captura limitada se traducirá en un modelo mucho más básico. Fuente: JVRB Nghiago

Aquí es donde las cosas requerir un poco de engaño, ya que el software tiene que ser capaz de identificar características similares a través de múltiples imágenes antes de que pueda construir el modelo. Esto se logra mediante el seguimiento de puntos específicos con algoritmos conocidos como Estructura-from-Motion (SFM) y el ajuste de paquete.

Posicionamiento de píxeles se puede seguir entre las imágenes de modelo y iniciales 3D de nueva creación, con el fin de realizar un seguimiento de las distancias y la visibilidad entre las partes de la escena. Fuente: UNC

A partir de este modelo de profundidad 3D, Google emplea algoritmos Multi-View-estéreo para calcular las distancias aproximadas entre los puntos en la escena, que se utiliza para formar un mapa de profundidad. Puntos de referencia se calculan utilizando la suma de las diferencias absolutas (SAD) de los valores RGB de los píxeles de la imagen. En otras palabras, las diferencias de color entre un grupo de píxeles crea un identificador único que se puede encontrar una y otra vez en diferentes imágenes para un punto de referencia. Para acelerar y optimizar el proceso, los puntos de referencia son tomadas de diferentes partes de las imágenes, como píxeles próximos entre sí son bastante propensas a tener profundidades muy similares.

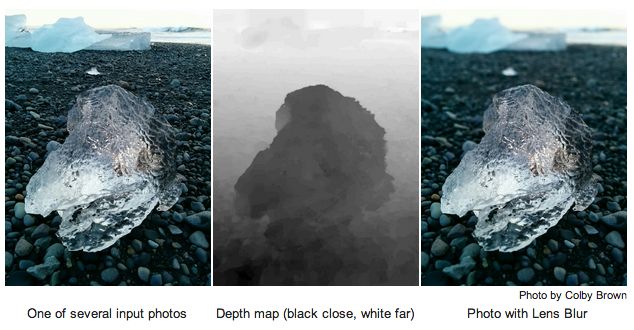

Al final, esto funciona de manera muy similar a la del ojo humano, en el que podemos calcular la distancia de un objeto por verlo desde dos ángulos ligeramente diferentes. La siguiente imagen muestra un ejemplo de la información de profundidad concluido calculada por la aplicación.

Habiendo calculado el mapa de profundidad, es simplemente un caso de desenfoque píxeles de profundidad similar para dar el punto focal deseada. Como varios puntos de referencia se almacenan ahora para la imagen, la información de la distancia se puede recuperar si el usuario desea ajustar el punto focal o nivel de desenfoque.

Hay un montón de matemáticas y codificación detrás de todo esto, pero los resultados realmente hablan por sí mismos.

![4.4.1 Android mejorará enormemente Nexus 5 cámara, rodando en pocos días [Actualización: el despliegue de ahora] 4.4.1 Android mejorará enormemente Nexus 5 cámara, rodando en pocos días [Actualización: el despliegue de ahora]](https://androidspan.ru/uploads/blockpro/65x50/2015-11/65x50_crop_android-4-4-1-will-massively-improve-nexus-5_1.jpg)